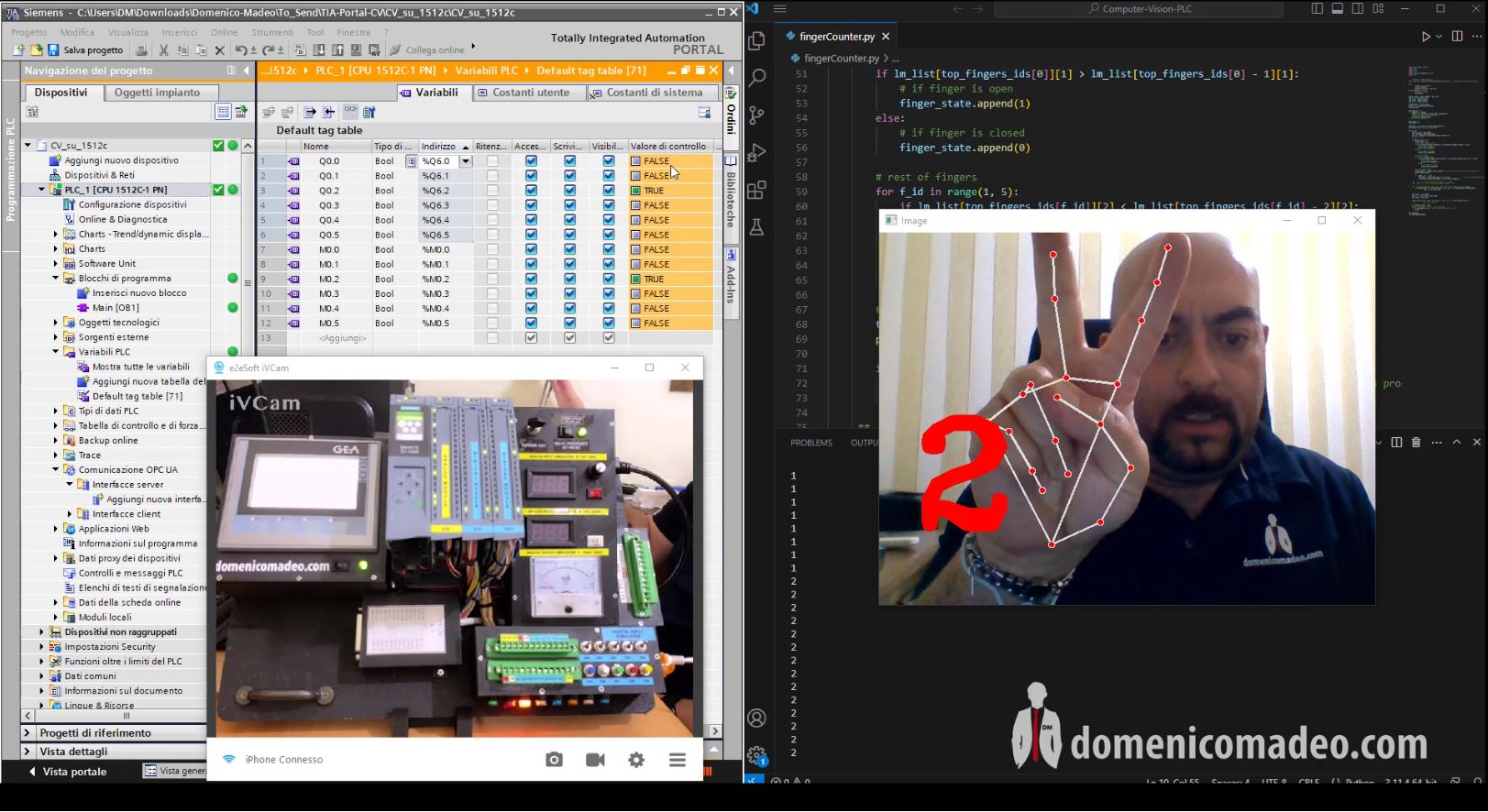

L’intelligenza artificiale applicata alle macchine, DEMO per azionare le uscite di un plc s7-1500 con le dite della mano.

Quando ho iniziato a studiare l’AI e più nel dettaglio la parte che a me interessa di essa cioè la Machine learning, il mio fine era quello di creare un collegamento diretto tra l’uomo e le sue parti e la macchina stessa, creare qualcosa che potesse permettergli di comunicare direttamente e parlarsi, in questo primo esempio programmo di usare la webcam per comunicare al PLC quali uscite azionarmi, mediante la lettura della posizione delle dita.

Insegnare ai nostri sistemi auutomatici a capire le posizioni della mano e ad azionare le uscite e quindi a fare ciò che vogliamo.

In questo video demo, mostro la possibilità di leggere la posizione delle dita e definire l’azionamento di uscite di un plc s7-1500 in base al numero indicato dalle dita.

L’algoritmo scritto in Python è collegato al Server OPC-UA tramite un’interfaccia Node-red, che comunica al PLC cosa vede il visore di Computer Vision mediante la libreria OpenCV di Python.

Prima simulerò il PLC con PLCSIM Advanced e poi lo vedremo su una CPU reale.

Naturalmente è un video demo che mostra le potenzialità di definire mediante il movimento e la visione del corpo umano l’azionamento di un attuatore, che siano le uscite PLC o Robot.

👉🏻👉🏻 𝙋𝙀𝙍 𝙎𝙀𝙈𝙄𝙉𝘼𝙍𝙄 𝙀 𝘾𝙊𝙍𝙎𝙄 𝙎𝙐 𝙌𝙐𝙀𝙎𝙏𝙊 𝘼𝙍𝙂𝙊𝙈𝙀𝙉𝙏𝙊 𝙍𝙀𝙎𝙏𝙊 𝘼 𝘿𝙄𝙎𝙋𝙊𝙎𝙄𝙕𝙄𝙊𝙉𝙀 👈🏻👈🏻